DeepMind全种族碾压《星际2》人类玩家,AI征服即时战略游戏之巅

官宣!DeepMind AI 开发的星际争霸 2 AI"AlphaStar"进化成了完全体"AlphaStar Final",三个种族(神族、人族和虫族)均达到欧服战网宗师组级别,最高达到 6275 分,在遵守所有游戏规则的情况下,超越了 99.8% 的欧服玩家!有关新版 AlphaStar 的论文也登上了 Nature 杂志。

与今年 1 月只会使用神族的状态相比,AlphaStar 不仅精通了三个种族,会玩四张地图,更重要的是,它的手速和视野被限制到了跟人类相似的水平,以职业选手 TLO 的有效 APM 为校准基准,最多在 5 秒内完成 22 个不重复指令,操作延迟限定在 110 毫秒左右,不会再出现 1500 峰值 APM 的变态操作,也不会看到当前镜头以外的单位信息,但是可以选中它们(人类也可以通过编队实现这一操作)。

根据 DeepMind 介绍,AlphaStar 于今年 7 月正式登陆星际 2 战网,开始以匿名的方式和欧服天梯玩家对战,以确保得到公平对战。得益于新算法的帮助,完全体版本 AlphaStar Final 的竞技水平突飞猛进。

在不到 4 个月的时间里,它使用每个种族进行了 30 场天梯比赛,三个种族的水平都达到了宗师级别:神族 6275 分(胜率 83%),人族 6048 分(胜率 60%),虫族 5835 分(胜率 60%)。

图 | AlphaStar 的天梯表现(A);AlphaStar 对战各种族的胜率和分数(B);AlphaStar 和职业选手 TLO 的有效 APM 对比(C)(DeepMind)

星际 2 职业选手 DARIO“TLO”WNSCH 表示,“我觉得 AlphaStar 的水平令人印象深刻,它非常擅长评估它所处的战略地位,十分清楚什么时候交战,什么时候撤退。尽管 AlphaStar 拥有精准的控制操作,但并不会给人一种非人类的感觉,完全不是人类理论上无法达到的水平。总之,跟它对战就像跟真人玩星际一样。”

开创性的“组队训练”

在战网上,AlphaStar 共有三个版本同时进行测试,后缀分别是 Supervised,Mid 和 Final,其中最弱的版本是 Supervised,最强的则是 Final。三者最大的不同点在于模型训练方式和训练时间。

Supervised 版本使用了监督学习和强化学习进行训练,从人类玩家的录像中学习游戏技巧,因此使用的战略也都受到了人类玩法的启发。最终它达到了钻石组水平,约为 3700 分。

为了进一步提升竞技水平,DeepMind 研究团队试图从根本上改变 AI 的训练方式。目前常用的 AI 训练策略主要围绕“自我对弈(selfplay)”和“虚拟自我对弈(Fictitious selfplay)”展开。

自我对弈是一个开放式的学习过程。在训练时,人类只需要设定好游戏规则和环境,让 AI 不断跟自己对打,就可以使其逐渐熟悉游戏规则,掌握获胜要领,从而不断提升游戏水平。

图 | 自我对弈和引入 Exploiter 的区别:后者可以帮助 AI 主体制定更全面的策略(DeepMind)

但自我对弈也存在局限性,AI 可能会因为掌握了新的获胜技巧,而忘记之前学习的、与现有技巧矛盾的技巧。

为了解决这一问题,“虚拟自我对弈(Fictitious selfplay)”策略诞生了。OpenAI 开发的 OpenAI Five 就是基于自我对弈等策略学会了如何打 Dota,在有条件限制的前提下战胜了人类 Dota 2 职业队伍和世界冠军。

DeepMind 研究团队一开始也是用这种方式训练 AlphaStar,但他们发现 AI 的竞技水平似乎达到了瓶颈,无法突破,于是他们发明了一种新的“联盟训练(League Training)”策略。

前面提到的 Mid 和 Final 版本都是联盟训练策略的产物,只不过 Mid 训练了 27 天,Final 训练了 44 天,两者天梯相差 1000 分左右。

这种策略借鉴了人类玩家提升水平时使用的办法:寻找训练伙伴,以组队的方式训练。有些队友存在的意义不在于替代玩家击败对手,而在于帮助玩家发现缺点或者训练特殊战术,从而提升竞技水平。

图 | 在 Exploiter 的帮助下,AI 主体学会了应对速推流(DeepMind)

研究人员在“联盟”系统中设计了三种 AI 代理类型。

一类是 AI 主体,使用“优先虚拟自我对弈”机制,目的就是为了获得胜利。剩下两类都是训练伙伴,被称为 Exploiter(漏洞发现者),其中一类负责寻找 AI 主体存在的漏洞,比如对战过程中过分追求微操作而忽视了经济发展,鼓励 AI 主体改进这些弱点;另一类则负责寻找联盟系统的漏洞,矫正系统整体的发展方向。

简单来说,DeepMind 认为仅仅告诉 AI“你必须要赢”是不够的,因此给 AI 安排了两个专门挑刺的训练伙伴组成一个联盟,专门找出 AI 打游戏时哪里做的不好,再反馈给 AI,帮助它改进这些缺点。由此看来,这两个伙伴更像是扮演了教练的角色。

研究人员强调,为了保证训练伙伴的多样性和 AI 主体的学习速度,两个 Exploiter 会定期重新初始化。

模仿人类

DeepMind 还指出了 AI 打星际时的另一个难题:探索(Exploration)。

星际 2 有着复杂多变的环境,在一个时间点可以执行的动作空间高达 10^26 种,哪些行动可以带来胜利,哪些行动会导致失败,AI 不可能在短时间内穷尽,在零基础的前提下想要从中寻找获胜之道非常困难。

虽然 DeepMind 给三个种族训练了三个独立的神经网络,保证其战术的独特性和一致性,但同一种族的开局仍然存在很多不同的打法,是稳扎稳打攀科技,还是直接速推对手,很多时候都要根据局势改变已有策略,见招拆招。

图 | AI 主体找到了克服缺陷的办法(DeepMind)

因此 AlphaStar 在训练前期就使用了模仿学习(Imitation Learning)来学习人类策略,模仿人类的打法,然后在自我对弈过程中不断摸索和开发新的策略,但也会在一定程度上更偏向模仿人类策略,不会只遵循一种开局方式。

除此之外,研究人员还用到了离线强化学习(offpolicy),用过去游戏中总结的策略更新和完善现有策略。

“AI 可以自己制定不同于人类的策略,这很令人兴奋。现在对 APM 和视野的限制将 AI 和人类拉到了相似的起点,让游戏更具吸引力了。不过作为职业选手,我仍然可以发现它存在某些弱点,”星际 2 职业选手 Grzegorz "MANA" Komincz 表示,他曾是 AlphaStar 的手下败将。

归功于模仿学习、强化学习和联盟训练策略,DeepMind 训练出了“完全体”AlphaStar,尽管仍然存在漏洞,但从只会一个种族到全种族称霸,从因为 APM 饱受争议到限制 APM 晋级宗师,AlphaStar Final 的表现的确令人刮目相看,甚至有可能启发人类玩家开发新的战术。

不过成为星际 2 宗师并非 DeepMind 团队的最终目标,他们希望借助复杂多变的游戏世界测试 AI 系统的潜力,试图找出通向通用人工智能技术的核心要素,将类似的 AI 系统转化成具备实用价值的、为人类服务的工具。

DeepMind 还放出了 AlphaStar 的对战视频,链接如下:

https://deepmind.com/research/opensource/alphastarresources

本文:DeepMind全种族碾压《星际2》人类玩家,AI征服即时战略游戏之巅

文章地址:http://www.alipaygame.com/nationalnews/120690.html 转载请保留链接地址

上一篇:LOL“悠米的按键”火了,扣掉QER,只留一个W就好!

下一篇:B站和品牌金主玩在一起,1亿用户还不离不弃,网友:我服了

标签:DeepMind全种族碾压《星际2》人类玩家,AI征服即时战略游戏之巅

最新图文资讯

《4399天骄无双》龙争虎斗 卧虎藏龙

《4399天骄无双》龙争虎斗 卧虎藏龙

《4399天骄无双》中激烈好玩的阵营玩法当属“龙争虎斗”活动,玩家可以在游戏主界面战场大厅进入龙争虎斗。活动开启时间为每天20:00-20:30。游戏中卧虎藏龙,千万小心哦!...

《4399烈斩》皇城争霸 能者居之

《4399烈斩》皇城争霸 能者居之

胜者为王,败者为寇!若想要想成为区服中的最强王者,必然要经过精挑细选。在《4399烈斩》中,皇城战是选拔佼佼者的战斗,唯有具备高战力高操作的玩家,才能称霸全服。巍峨皇城,城主宝座,乃能者居之!天下强者汇聚皇城,究竟谁能问鼎皇城,谁能号令群雄、权倾天下!优胜劣汰,一切尽在...

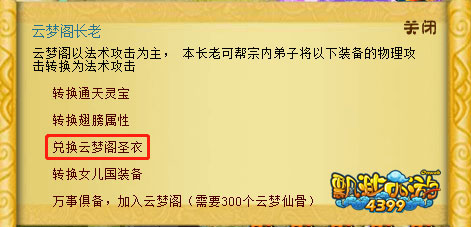

《4399飘渺西游》新门派云梦阁转职攻略

《4399飘渺西游》新门派云梦阁转职攻略

云梦阁乃世上最形影不定的存在,是有“云梦之灵”之称的幻术大师莫仙灵所创。《4399飘渺西游》全新门派云梦阁的登场,吸引了不少弟子转入其门下。今天就来为大家解答一下,如何转职到云梦阁,有兴趣的弟子们快来了解一下吧!...